کیونپ OpenVINO

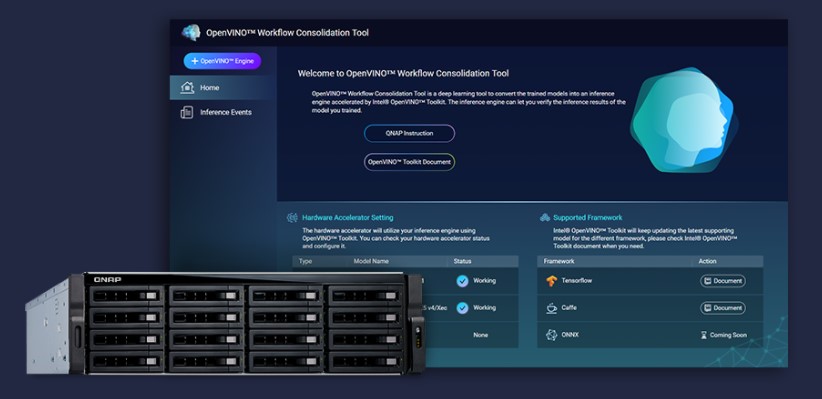

OpenVINO (OWCT) یک ابزار یادگیری عمیق برای تبدیل مدلهای آموزش دیده به یک سرویس استنباط است که با Open Visual Inference and Neural Network Optimization یا همان جعبه ابزار Intel Distribution of OpenVINO تسریع میشود و به توزیع اقتصادی راه حل های بینایی با استفاده از هوش مصنوعی کمک میکند.

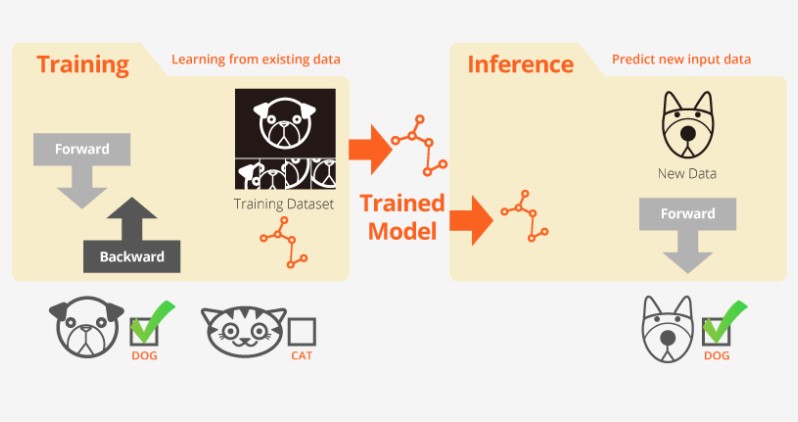

آموزش و استنباط

«آموزش» زمانی است که سیستم از دادههای موجود یاد میگیرد و «استنباط» زمانی است که از یک مدل آموزشدیده برای پیشبینی مفید با دادههای دنیای واقعی استفاده میشود.

سرعت بخشیدن، سادهسازی و تأیید استنباط یادگیری عمیق

توزیع جعبه ابزار OpenVINO

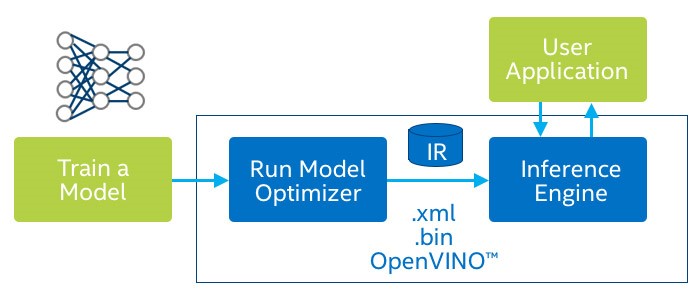

مجموعه ابزار OpenVINO به شما کمک میکند تا بینایی رایانهای با عملکرد بالا و یادگیری عمیق برنامههای بینایی را بهراحتی دنبال کنید. این امکان را برای یادگیری عمیق در مورد شتابدهندههای سختافزاری و اجرای ناهمگن آسان در سراسر سیستمعاملهای Intel ازجمله CPU، GPU، FPGA و VPU نیز فراهم میکند. اجزای اصلی شامل:

• مجموعه ابزار Intel Deep Learning Deployment (بهینه ساز مدل و موتور استنباط)

• توابع بهینهشده برای OpenCV * و OpenVX *

• آمادهسازی بیش از 15 نمونه کد و مدل از قبل آموزشدیده برای استقرار آسان

ابزار OpenVINO کمک میکند تا بینایی رایانهای با عملکرد بالا و یادگیری عمیق برنامههای بینایی شکل بگیرد

استنباط سریع تر هوش مصنوعی شما برای بینایی رایانه

مزایای اصلی استفاده از ابزار تطبیق گردش کار (OWCT) OpenVINO:

• سرعت دادن

• بهینه سازی

• رابط کاربری گرافیکی

سرعت دادن

جعبهابزار بهینه سازی بصری شامل یک کتابخانه منبع باز است که به کاهش زمان توسعه کمک میکند و استنتاج یادگیری عمیق و استفاده از راهحلهای بصری را ساده میکند.

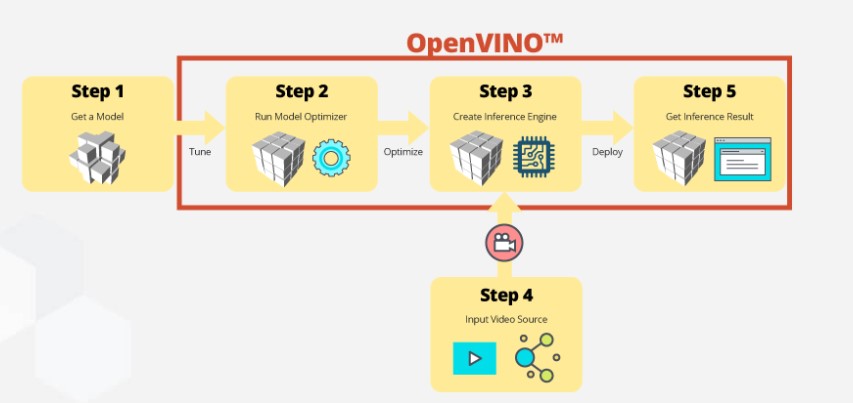

استنباط گام به گام با OWCT

OWCT تمام ویژگیهای لازم ابزار بهینهسازی بصری را تلفیق میکند تا به شما برای داشتن موتور استنباط و بررسی نتایج استنتاج مدل کمک کند. بهسادگی میگذارد برنامه را دنبال کنید و فقط در چند مرحله موارد را تنظیم کنید.

OWCT تمام ویژگیهای لازم ابزار بهینهسازی بصری را تلفیق میکند

مجموعه ابزار OpenVINO علاوه بر جستجو یا آموزش مدلهای خود، مدلهای از قبل آموزشدیده بهینه شده Intel را نیز بهعنوان موتور استنتاج در برنامههای کاربر ارائه میدهد.

مجموعه ابزار بهینه سازی بصر شامل دو مجموعه مدل بهینهشده است. شما میتوانید این مدلها را مستقیماً به محیط خود اضافه و پیشرفت خود را تسریع کنید.

• تشخیص سن و جنسیت

• تشخیص تقاطع و چهارراه

• موقعیت سر در رباتها

• موانع امنیتی

• تشخیص خصوصیات خودرو

• و سایر موارد

QNAP NAS بهعنوان یک سرور استنتاج

جعبهابزار OpenVINO حجم کار را در سراسر سختافزار Intel (ازجمله شتاب دهندهها) گسترش میدهد و عملکرد را به حداکثر میرساند. QNAP NAS مستقر در Intel با استفاده از ابزار تلفیق گردش کار بهینه ساز بصری یک سرور استنباط ایدهآل ارائه میدهد که به سازمانها در ساخت سریع سیستم استنتاج کمک میکند. یک بهینه ساز مدل و موتور استنباط، قابلاستفاده در دید رایانهای با کارایی بالا و تأخیر کم و همچنین با انعطاف پذیری مناسب است که نتیجهگیری یادگیری عمیق را بهبود میبخشد. توسعهدهندگان هوش مصنوعی میتوانند مدلهای آموزشدیده را برای استنباط در QNAP NAS مستقر کرده و شتابدهندههای سختافزاری را بر اساس سیستمعامل Intel نصب کنند تا به عملکرد بهینه برای اجرای استنباط برسند.

مدیریت آسان موتور استنتاج

عملکرد بهتر با کارتهای شتابدهنده

جعبهابزار OpenVINO با استفاده از یک API مشترک از اجرای ناهمگن در میان شتاب دهندههای بینایی رایانه (CPU، GPU، FPGA و VPU) جهت بهینهسازی خاص دستگاه پشتیبانی میکند.

شتاب دهنده FPGA

موستانگ - F100-A10

• Intel Arria 10 GX 1150 FPGA

• PCIe 3.0 x8

• کوتاه، نیم سایز، دو شیارِه

شتاب دهنده FPGA

شتاب دهنده VPU

موستانگ - V100-MX8

• راهحل Intel Movidius

• 8x Myriad™ X VPU

• PCIe 2.0 x4

• کوتاه، نیم سایز، یک شیارِه

شتاب دهنده VPU

توجه داشته باشید

• QTS 4.4.0 (یا بالاتر) و OWCT v1.1.0 برای QNAP NAS موردنیاز است.

• برای استفاده از محاسبات کارت FPGA در QNAP NAS، عملکرد عبور VM غیرفعال میشود. برای جلوگیری از اتلاف احتمالی دادهها، اطمینان حاصل کنید که تمام وظایف جاری NAS قبل راهاندازی مجدد سیستم به پایان رسیده باشد.

مدلهای پشتیبانی شده کامل :

TVS-x72XT: CPU, iGD, VPU (Note: TVS-472XT is not supported)، (توجه: TVS-472XT پشتیبانی نمیشود)

TVS-x72XU: CPU, iGD, FPGA, VPU

TS-x82: CPU, iGD, FPGA, VPU

TS-x83: CPU, FPGA, VPU

TS-x85: CPU, FPGA, VPU

TS-x88: CPU, FPGA, VPU

TS-x89U: CPU, FPGA, VPU

OpenVINO و آرم OpenVINO علائم تجاری شرکت Intel یا شرکتهای تابعه آن در ایالاتمتحده و یا سایر کشورها هستند.